Wavy Transformerとは

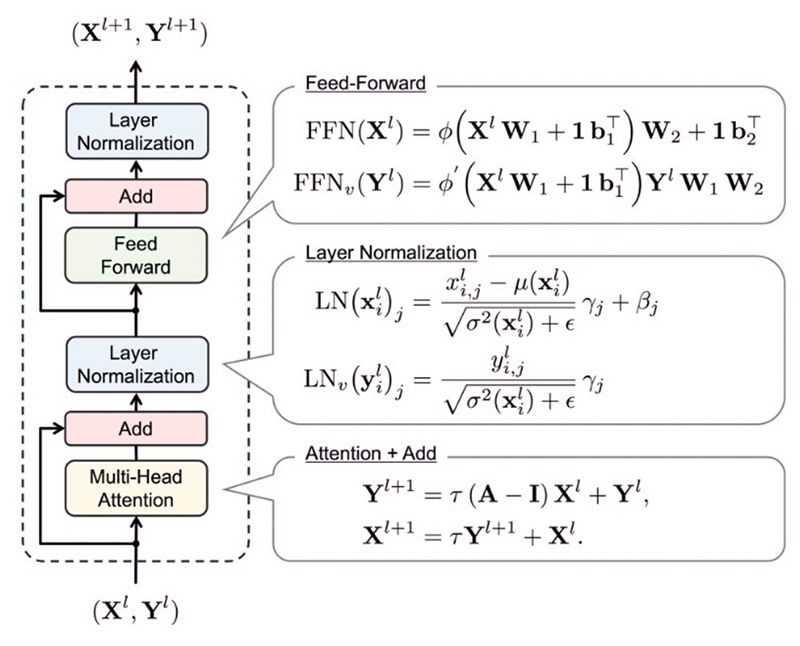

Wavy Transformerは、従来のTransformerが層を深く重ねるとトークンの特徴表現が拡散し均一化してしまう「オーバースムージング(過度な平滑化)」という課題に対し、情報の伝播を物理学的な「2階の波動ダイナミクス」として再定義することを提案した新たなTransformerです。本モデルは、従来の拡散的な挙動の代わりに、エネルギーを保存する波動の性質を取り入れた新しい注意機構(Attention)に加え、連鎖律に基づく物理的な「状態」と「速度」の関係性を維持する独自のフィードフォワード層や正規化層を導入しています。これにより、計算コストや学習パラメータを最小限に抑えつつ、追加のハイパーパラメータ調整なしで、自然言語処理(NLP)やコンピュータビジョン(CV)の主要ベンチマークにおいて従来モデルを一貫して上回る性能を発揮します。

参考⽂献

-

Satoshi Noguchi and Yoshinobu Kawahara, Wavy Transformer, Advances in Neural Information Processing Systems (NeurIPS 2025).

https://neurips.cc/virtual/2025/loc/san-diego/poster/116533

https://www.jamstec.go.jp/j/about/press_release/20251121/

https://github.com/noguchisatoshi/Wavy-Transformer

https://arxiv.org/abs/2508.12787

お問い合わせ先

Email : satoshin[at]jamstec.go.jp

※お問い合わせの際は、[at]をアットマークに変えてください。